Powtórka z atrybucji

February 28, 2016

← poprzednia notka |Jest taka dziedzina nauki, w której większość przewidywań teoretycznych opiera się o symulacje modeli numerycznych; gdzie ich laboratoryjna weryfikacja jest utrudniona albo wręcz niemożliwa; gdzie obserwacje opisywanych przez teorię, naturalnie występujących fenomenów, wymagają nakładów liczonych w setkach milionów dolarów; gdzie surowe dane, między innymi zmierzone przez satelity, są skażone bardzo poważnymi błędami systematycznymi i wymagają homogenizacji; gdzie niektóre zespoły generują fałszywe obserwacje i próbują je potem opublikować, a samotni naukowcy na darmo walczą z konsensualną większością; i gdzie przez pół wieku nie udało się bezpośrednio zweryfikować jednego z głównych przewidywań tej teorii.

Jak się pewnie domyślacie, powyższy opis dotyczy relatywistycznej fizyki grawitacji [1], jednak instytucjonalne podobieństwo do klimatologii nie jest wcale takie powierzchowne. Klimatologia jest przecież poddziedziną geofizyki, która jest poddziedziną planetologii, która z kolei jest poddziedziną astrofizyki. Naukowcy zajmujący się gwiazdami neutronowymi, aktywnymi jądrami galaktyk, formowaniem odległych układów słonecznych, czy w końcu zmianami klimatu na Ziemi, spotykają problemy podobnej natury, i rozwiązują je przy pomocy podobnych narzędzi. Czasami były to nawet te same narzędzia, i ci sami naukowcy, jak Karl Schwarzschild i Subrahmanyan Chandrasekhar, którzy stworzyli podwaliny pod teorią transferu radiacyjnego oraz czarnych dziur.

Z jakiegoś powodu łatwiej jest nam jednak uwierzyć w zmierzenie zmian długości ramienia interferometru liczącą , spowodowane zderzeniem dwóch astrofizycznych obiektów odległych o 410 megaparseków od Ziemi, a jeszcze dalej od naszej codziennej intuicji; niż w to że można wykryć antropogeniczną zmianę klimatu wyrażającą się globalnym ociepleniem o niemal jeden stopnień Celsjusa.

Po ogłoszeniu detekcji GW150914 [2] nie czytałem w polskiej prasie felietonów o globalnym szwindlu i wyłudzaniu grantów przez kolaborację LIGO; nikt nie marudził, że wyniki są niereplikowalne, bo europejski detektor Virgo był wyłączony, a IceCube i ANTARES nie wykryły powiązanej ze zderzeniem emisji neutrin; nie widziałem sceptyków argumentujących, że skoro Joseph Weber pomylił się ogłaszając odkrycie fal grawitacyjnych 50 lat temu, więc może i tym razem naukowcy się mylą; albo internetowych mądrali zastanawiających się, czy na pewno uwzględniono fakt że oprócz fal grawitacyjnych interferometr LIGO może mierzyć wibracje ziemskiego pochodzenia.

Chciałbym więc wykorzystać ten chwilowy przypływ wiary w możliwości i osiągnięcia nauki do przedyskutowania problemu znanego w literaturze klimatologicznej jako detekcja i atrybucja: czyli wykrycia, że jakieś zdarzenie miało miejsce, i ustalenia, co było jego przyczyną. Żeby było łatwiej, będę pisać o globalnym ociepleniu, rozumianym jako uśrednione w dużych skalach przestrzennych, długoterminowe zmiany temperatury; detekcja i atrybucja może się jednak odnosić do innych parametrów (np. opadów, wysokości tropopauzy, pozycji ITCZ, czy pokrywy lodu pływającego).

Zacznijmy od prostej obserwacji, że jeśli jakieś zdarzenie miało miejsce, to nie mogło nie mieć miejsca, i vice versa. Innymi słowy, pomijając dziwne kwantowe historie, nie mamy możliwości bezpośredniego porównania dwóch alternatywnych wersji historii: rzeczywistej z taką, w której do globalnego ocieplenia nie doszło, albo w której zderzenie czarnych dziur które wygenerowało sygnał GW150914 nie zostało zarejestrowane 14 września 2015 roku przez LIGO. Oznacza to, że musimy mieć oczekiwania odnośnie tego, jak wyglądałyby obserwacje w obecności sygnału, który chcemy wykryć, oraz jeśli tego sygnału w ogóle nie ma, i oczekiwania te muszą zostać sformalizowane w postaci jakiegoś modelu (statystycznego).

Detekcja polegać będzie na odróżnieniu tego sygnału od szumu, atrybucja na sprawdzeniu, jaki mechanizm odpowiada za wygenerowanie sygnału.

Detekcja zmian klimatu

W przypadku zmian klimatu (nie tylko antropogenicznych), przypadkiem referencyjnym, albo hipotezą zerową którą chcielibyśmy odrzucić, jest oczywiście brak zmiany klimatu. Precyzyjniej, klimatolodzy mówią tutaj o niewymuszonej zmienności klimatycznej, bo nawet gdyby skład atmosfery się nie zmieniał, aktywność słoneczna pozostawała stabilna, wulkany przestały wybuchać, a orbita Ziemi zmieniać, oczekiwalibyśmy niewielkich wahań stanu atmosfery wskutek chaotycznych interakcji pomiędzy oceanami a atmosferę.

Spodziewamy się jednak, że wskutek tychże wahań średnia temperatura globalna nie będzie się za bardzo zmieniać. W pierwszym przybliżeniu wynika to z prawa zachowania energii: jej ilość uciekająca z planety w postaci promieniowania długofalowego jest zależna od temperatury, a założyliśmy, że ilość energii docierającej do szczytu atmosfery nie będzie się zmieniać (bo warunki brzegowe pozostają niezmienne). Średnio, wzrost temperatury globalnej skutkować będzie zwiększoną emisją, a zatem schłodzeniem radiacyjnym planety, i na odwrót: spadek temperatury oznacza zmniejszenie efektywności chłodzenia radiacyjnego, i akumulację energii w układzie.

Ten rodzaj sprzężenia ujemnego zwykło w klimatologii nazywać się sprzężeniem Plancka, i nakłada ono silne ograniczenie na to jak może zmieniać się średnia temperatura globalna niewymuszonego systemu klimatycznego, oraz jak taki system może reagować na wymuszenia radiacyjne. O tym, że takie sprzężenie istnieje i stabilizuje klimat planety, można przekonać się wyglądając za okno: jak dotąd, w ciągu ostatnich kilkaset milionów lat Ziemia nie zmieniła się ani w lodową kulę, ani nie utraciła całej wody w katastrofie cieplarnianej.

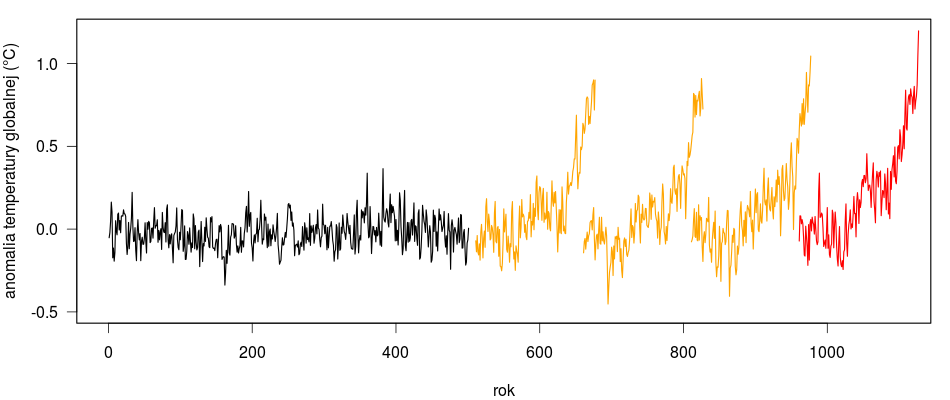

Szumem, w którym klimatolodzy szukają sygnału globalnego ocieplenia, są więc wahania średniej globalnej temperatury niewymuszonego systemu klimatycznego, oraz niepewności związane z oszacowaniem wartości tejże średniej. Statystyczne właściwości tego szumy można oszacować na podstawie obserwacji, oraz symulacji z użyciem modeli klimatu. W obu przypadkach otrzymujemy podobną odpowiedź: w skali 50 i więcej lat, średnia globalna temperatura Ziemi nie powinna zmieniać się, w 95% przypadków, o więcej niż 0,2°C.

Detekcja fal grawitacyjnych

Jeśli chodzi o LIGO to szumem jest, no cóż, po prostu szum: emisji laserowej, wibracje oprzyrządowania, promieniowanie kosmiczne, szum związany z absorpcją promieniowania lasera przez wirujące lustra interferometru, wstrząsy sejsmiczne, czy wariacje ciśnienia ultra-wysokiej próżni wewnątrz tuneli detektora. Własności statystyczne szumu różnego pochodzenia można oszacować na podstawie teorii i obserwacji, jeśli więc prawdopodobieństwo uzyskania jakiejś obserwacji jako losowego szumu jest mało prawdopodobne, zaobserwowane zdarzenie jest uważane za sygnał.

Aby analogia pomiędzy detekcją zmiany klimatu a detekcją fal grawitacyjnych była pełniejsza, kategorię szumu w tym drugim przypadku trzeba byłoby zapewne ograniczyć wyłącznie do szumu związanego z instrumentami pomiarowymi (jak gaussowski shot noise), a pozostałe źródła (transient noise) uznać za analogię do “wymuszonej zmiany klimatu”. Podział ten nie do końca odpowiada rzeczywistym technikom używanym przez LIGO, gdzie pierwszy etap detekcji (“online burst search”) niemal w czasie rzeczywistym11 W przypadku GW150914, z zaledwie trzyminutowym opóźnieniem. eliminuje w zasadzie wszystkie zdarzenia które nie wygenerowały fali o podobnym przebiegu w obu detektorach, a drugi etap to już właściwa atrybucja.

SNR

W praktyce szum prawie zawsze dominuje (gdyby było inaczej, wszystkie interesujące odkrycia dokonane byłyby już dawno temu), trzeba więc się trochę postarać by dostrzec nawet silny sygnał.

Przykładowo, pomiary temperatury w stacjach meteorologicznych wykonywane są kilka razy dziennie, z dobową amplitudą wynoszącą kilka czy kilkanaście stopni Celsjusza, i z amplitudą sezonową sięgającą, w ekstremalnych przypadkach, kilkudziesięciu stopni. Wykrycie wzrostu temperatury o wartości ułamka czy nawet kilku °C nie byłoby więc zawsze gwarantowane, i są miejsca na Ziemi, gdzie jeszcze nie da się zaobserwować lokalnego ocieplenia. Z pomocą przychodzi statystyka i prawo wielkich liczb: pole temperatury (a tak naprawdę anomalii temperatury) ma wystarczająco dużo stopni swobody, by średnia globalna miała stosunkowo mała zmienność, i wystarczająco mało stopni swobody, by lokalne wartości pola dało się określić przy pomocy niedoskonałych, ale nadpróbkowanych, obserwacji.

Innymi słowy, uśredniając tysiące obserwacji nie tylko uśredniamy lokalną pogodę w globalny klimat, ale redukujemy wpływ niepewności pomiarowych (niepewności te można też zmniejszyć homogenizując obserwacje, ale to już inna historia).

Ktoś mógłby słusznie zauważyć, że jest to strategia dość prymitywna, i jeśli obecnie działa, to dlatego że sygnał związany z antropogeniczną zmianą klimatu jest na tyle silny, że da się go znaleźć nawet prostymi metodami. Gdyby sygnał był słabszy - a tak jest w przypadku ocieplenia pierwszej połowy XX wieku, albo zmian innych parametrów systemu klimatycznego - redukowanie sygnału do zero-wymirowego punktu, średniej globalnej, może nie być najbardziej optymalną metodą, i pozbawiać nas informacji która wystarczyłaby do jego skutecznej detekcji.

W praktyce szuka się więc sygnału w przestrzeni wielowymiarowej, i to w tej jego części, w której jest mniej szumu. Przykładowo, jeśli weźmiemy dwuwymiarową mapę temperatury powierzchni planety, i sprawdzimy jak się lokalnie zmienia w okresie kilkunastu lat, łatwo można dostrzec że najmniejsza zmienność temperatur występuje w tropikach. Nawet jeśli spodziewany sygnał - wzrost temperatury - na wyższych szerokościach geograficznych ma większą amplitudę, stosunek sygnału do szumu może być, i zwykle jest, lepszy na niższych szerokościach geograficznych (oddzielną kwestią jest to, czy mamy z tego rejonu wystarczająco dobre obserwacje umożliwiające detekcję).

Szum dominuje też pomiary wykonane przez detektor LIGO. Tak naprawdę przez pięć sezonów obserwacji, od 2002 do 2005 roku, LIGO mierzyło wyłącznie szum, a ulepszenie detektora w 2010 roku nie poprawiło jego czułości w stopniu wystarczającym, by dało się wykryć sygnał związany z falami grawitacyjnymi. Dopiero kolejny upgrade, zakończony w 2015 roku, poprawił kilkanaście razy czułość interferometru, i sprawił że pierwsza detekcja przyszła niemal od razu po włączeniu maszyny, a właściwie podczas ostatniej, ósmej fazy testów, przed rozpoczęciem właściwego sezonu obserwacyjnego. Jak pisał kilka tygodni wcześniej jeden z członków zespołu

The purpose of those early engineering runs was to test out the ability of our data analysis systems to handle the large amount of data we will collect. As parts of aLIGO were installed, we replaced the simulated data from that component with real data. ER8 was our first test of all of the instrument without anything being simulated. While the purpose of this data is to test the stability of the whole system and to find other small bugs, we are still running all of our data analysis methods over the collected data. We don’t expect to find a gravitational wave in this data, but if we have compelling reason to believe that we really did see something we will certainly pursue it as a real detection. Don’t get too excited, though, since there are no indications that we collected a gravitational wave.

Obecna czułość LIGO jest tak duża, że można się spodziewać, iż od oficjalnego rozpoczęcia obserwacji 17 września 2015 roku (które było tylko “przykrywką” dla weryfikacji sygnału zarejestrowanego trzy dni wcześniej) fale grawitacyjne wykrywa kilka razy w miesiąc, a do kolejnej detekcji doszło już 12 października.

Nawet jednak przy obecnej czułości LIGO sygnał fal grawitacyjnych może łatwo zginąć w szumie, i żeby temu zapobiec detektor podłączony jest do tysięcy czujników (sejsmometrów, akcelerometrów, mikrofonów, termometrów, magnetometrów…) które mierzą parametry otoczenia i umożliwiają wychwycenie zdarzeń zaburzających pracę interferometru i odrzucenie (“zawetowanie”) segmentów danych zebranych w tym czasie. Dodatkowo, ponieważ LIGO ma dwa główne interferometry oddzielone od siebie o 3000 kilometrów (10 ms czasu podróży światła, a więc i fal grawitacyjnych), stosunkowo łatwo można wychwycić nieskorelowany szum nieznanego pochodzenia.

Piszę o tym nie tylko dlatego, że jest to całkiem interesujący temat, ale również dlatego, że w środowisku negacjonistów globalnego ocieplenia powszechna jest feteszyzacja surowych danych, a jakakolwiek analiza statystyczna jest traktowana z dużą podejrzliwością.

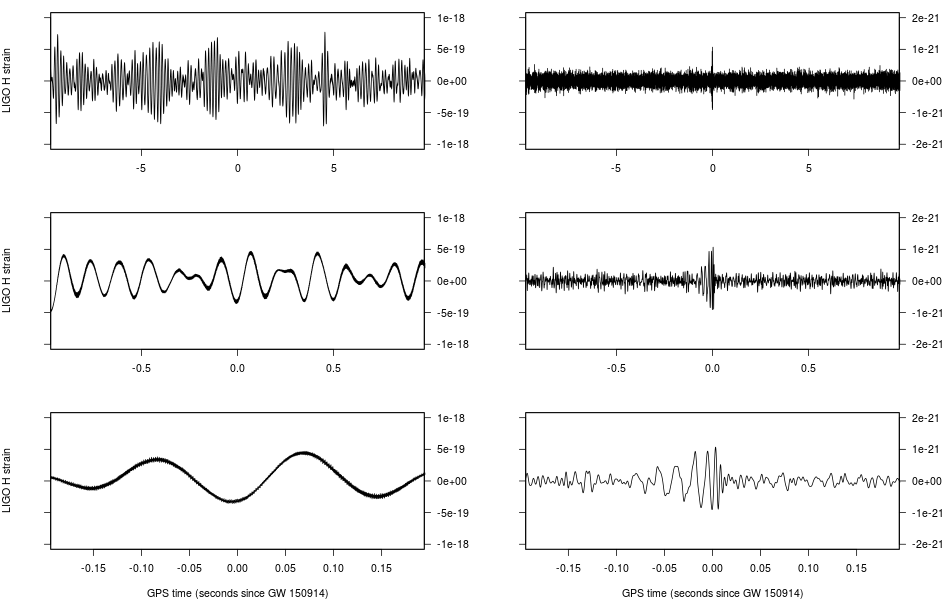

Tymczasem w przypadku LIGO “surowy” sygnał wygląda tak, jak na panelu po lewej:

Sygnał GW150914 zmierzony przez interferometr w Hanford.

I dopiero po wyfiltrowaniu częstotliwości związanych z szumem wiadomego pochodzenia pojawia się właściwy sygnał fal grawitacyjnych, o amplitudzie mniej więcej 1000 razy mniejszej.

Atrybucja

Wiemy już mniej więcej, jak wykryć sygnał wśrod szumu. Skąd jednak wiadomo, jakie zjawisko wygenerowało sygnał? Można sobie przecież wyobrazić - i argument taki bardzo często jest podnoszony przez laików - że globalne ocieplenie jest spowodowane czymś innym niż wzrost koncentracji gazów cieplarnianych, na przykład wzrostem aktywności słonecznej, albo zmianą kształtu orbity Ziemi. Analogicznie ktoś mógłby kwestionować detekcję fal grawitacyjnych. W końcu nikt nie widział na własne oczy żadnej czarnej dziury czy gwiazdy neutronowej, a tym bardziej nie był świadkiem ich zderzenia. Skąd naukowcy wiedzą, jak wyglądają wygenerowane wtedy fale grawitacyjne, i w jaki sposób odróżnić je można od, na przykład, trzęsienia ziemi albo uderzenia pioruna?22 Jak dowiedziałem się z lektury jednego z artykułów grupy LIGO, w każdej sekundzie gdzieś na Ziemi uderza 60 błyskawic, i w rachunku błędów trzeba było je uwzględnić.

Potrzebny jest do tego model, umożliwiający sformułowanie teoretycznych przewidywań związanych z obserwowalnymi efektami zjawiska, które chcemy wykryć. Zarówno w przypadku klimatu, jak i fal grawitacyjnych powstałych przy zderzeniu dwóch masywnych obiektów, analityczne rozwiązanie problemu nie wchodzi w rachubę, powszechnie używane są więc modele numeryczne, rozwiązujące układy zdyskretyzowanych cząstkowych równań różniczkowych. Sposób w jaki używa się tychże modeli przy atrybucji jest jednak trochę inny.

Obserwacji systemu klimatycznego mamy bowiem znacznie więcej, niż czarnych dziur. Wiemy mniej więcej, jak zmieniały się wymuszenia radiacyjne w ostatnich dwóch stuleciach: zmiany koncentracji dwutlenku węgla czy metanu potrafimy zrekonstruować z rdzeni lodowych, a od połowy ubiegłego wieku mamy już ich bezpośrednie pomiary; podobnie jest ze zmianami aktywności słonecznej, zmianami albeda wskutek wylesiania i zmianami gospodarki gruntów, i tak dalej. Wystarczy wrzucić te dane do modelu klimatu, i będzie on potrafił, w oparciu o znane nam prawa fizyki, obliczyć sygnał wynikający ze zmiany tychże wymuszeń radiacyjnych, zarówno każdego z osobna jak i wszystkich razem.33 Przy czym o ile zwykle do atrybucji zmian klimatu używa się “dużych” modeli, Earth System Models, ta sama zasada działałaby w przypadku prostszych modeli analitycznych. A ponieważ wyliczona z teorii amplituda ocieplenia związana ze wzrostem koncentracji dwutlenku węgla i gazów cieplarnianych zgadza się z wielkością obserwowanego ocieplenia; a zmiany temperatur wywołane przez alternatywne czynniki się z obserwacjami nie zgadzają, stąd też klimatolodzy mogą z dużym prawdopodobieństwem przypisać większość globalnego ocieplenia z ostatnich 50-60 lat czynnikom antropogenicznym [3].

Zmiany temperatury globalnej w 500-letniej symulacji niewymuszonej zmienności klimatycznej (czarny), trzech symulacjach “historycznych” globalnego ocieplenia modelu NorESM1-M (źółty), oraz według obserwacji (czerwony, dane Met Office). Symulacje historyczne (1850-2005) zostały przedłużone o 11 lat symulacji przyszłych zmian klimatu wiązek RCP45, RCP60 i RCP85.

W przypadku fal grawitacyjnych powstałych przy zderzeniu dwóch masywnych obiektów opisująca je teoria powstała sto lat temu, ale dobre modele numeryczne opisujące przebieg całego zjawiska pojawiły się dopiero w ostatniej dekadzie. Ponieważ LIGO nasłuchuje fal grawitacyjnych “na ślepo”, parametry modelu opisującego dane zderzenie są dopasowywane do obserwacji: ze skompilowanej wcześniej bazy danych około 250 tysięcy zderzeń różnego typu wybrany został sygnał najlepiej pasujący do tego, który faktycznie zmierzono. Oczywiście, znana nam fizyka zna tylko jeden rodzaj obiektów o masie kilkadziesiąt razy większej od Słońca, które mogą krążyć wokół siebie na orbitach o okresie liczonym w setnych częściach sekundy.

Kiedy więc następnym razem jakiś sceptyk klimatyczny wyśmieje pomysł używania modeli numerycznych celem udowodnienia przyczyny globalnego ocieplenia, spytajcie się go co sądzi o odkryciu fal grawitacyjnych.

Lektura dodatkowa

1. Satelity i homogenizacja: Mam na myśli analizę rezultatów Gravity Probe B streszczoną tutaj. Krótkie podsumowanie z jednego z współautorów:

Our simple pre-launch data analysis that could be run quickly in Matlab on a single desktop computer was converted into a sprawling code that took about a week to run on a 44-core computer cluster. In the end, a 20% estimate of the frame dragging effect, consistent with GR, resulted. This was not the 1% measurement that we were hoping for, but it is still one of the best and most convincing measurements of frame-dragging to date.

Fałszerstwa: tak naprawdę “fałszerstwa”, bo chodzi o ślepe testy w których w tajemnicy przed zespołem wstrzykiwano symulowane sygnały wyglądające dokładnie tak, jak powinny wyglądać fale grawitacyjne. Jedna z takich symulacji, zarejestrowana 16 września 2010 roku, zaskutkowała przygotowaniem trzech artykułów i konferencji prasowej, i dopiero w marcu następnego roku kilkaset osób z kolaboracji LIGO i Virgo dowiedziało się, po otworzeniu “tajnej” koperty z listą ślepych testów, że rzekoma detekcja fal grawitacyjnych była jednym z nich.

Walka z konsensusem: smutna historia Josepha Webera i jego odkrycia fal grawitacyjnych w latach sześćdziesiątych, została opowiedziana w wielu miejscach, ja szczególnie polecam Gravity’s Shadow Harry’ego Collinsa.

2. Abbot, et al. (2016): Observation of Gravitational Waves from a Binary Black Hole Merger.

Sposób detekcji sygnału przez LIGO opisany jest w Observing gravitational-wave transient GW150914 with minimal assumptions, dopasowanie parametrów modelu w GW150914: First results from the search for binary black hole coalescence with Advanced LIGO oraz Properties of the binary black hole merger GW150914.

Oszacowania częstości zdarzeń generujących fale grawitacyjne można znaleźć w The rate of binary black hole mergers inferred from advanced LIGO observations surrounding GW150914, modelowanie niepewności w Characterization of transient noise in Advanced LIGO relevant to gravitational wave signal GW150914 oraz starym raporcie Rainera Weissa z 1972 roku Electromagnetically Coupled Broadband Gravitational Antenna.

3. Teorię stojącą za atrybucją zmian klimatu można znaleźć u Hasselmann (1993) Optimal fingerprints for the detection of time-dependent climate change, przykłady jej zastosowania w Jones, et al. (2013) Attribution of observed historical near‒surface temperature variations to anthropogenic and natural causes using CMIP5 simulations. Przykładem atrybucji w oparciu o prostsze modele może być Imbers, et al. (2013) Testing the robustness of the anthropogenic climate change detection statements using different empirical models.